全てのアプリにAIがやってくる。ML Kitでアプリを作ろう。:Google I/O 2018

今回のポストは、Googleの開発者会議、Google I/Oがテーマです。

Facebookのf8(5/1-2)、GoogleのGoogle I/O(5/8-10)と立て続けの開催で、ようやくこの週末にGoogle I/Oの初日のKeynote(動画:約2時間)とDeveloper Keynote(動画:約1時間)を見終わりました。

2016年に「Mobile ファースト」から「AI ファースト」への転換を宣言してから、Google I/Oでは常に「AIの進化」について語られてきました。

以下は、過去二年の私のポストです。

今回も、昨年と同様、目新しいことはそれほどないという印象ですが、Googleにおける「AIファースト」がより進み、できることや提供される機能がより一層豊富になったということを感じさせる内容でした。

今回のポストでは、初日の三時間のキーノート(Main Keynote / Developer Keynote)の中から、多くの人に関係するであろうGoogleのAIの「7つの進化ポイント」を中心に書きたいと思います。

- AIの進化①:ML Kit

- AIの進化②:AR Core

- AIの進化③:Google Assistant

- AIの進化④:Android

- AIの進化⑤:Waymo

- AIの進化⑥:Google Lens

- AIの進化⑦:TPU

AIの進化①:ML Kit

一つ目は、「ML Kit」です。

私が今回のI/Oの中で、もっともインパクトが大きいと感じた発表です。

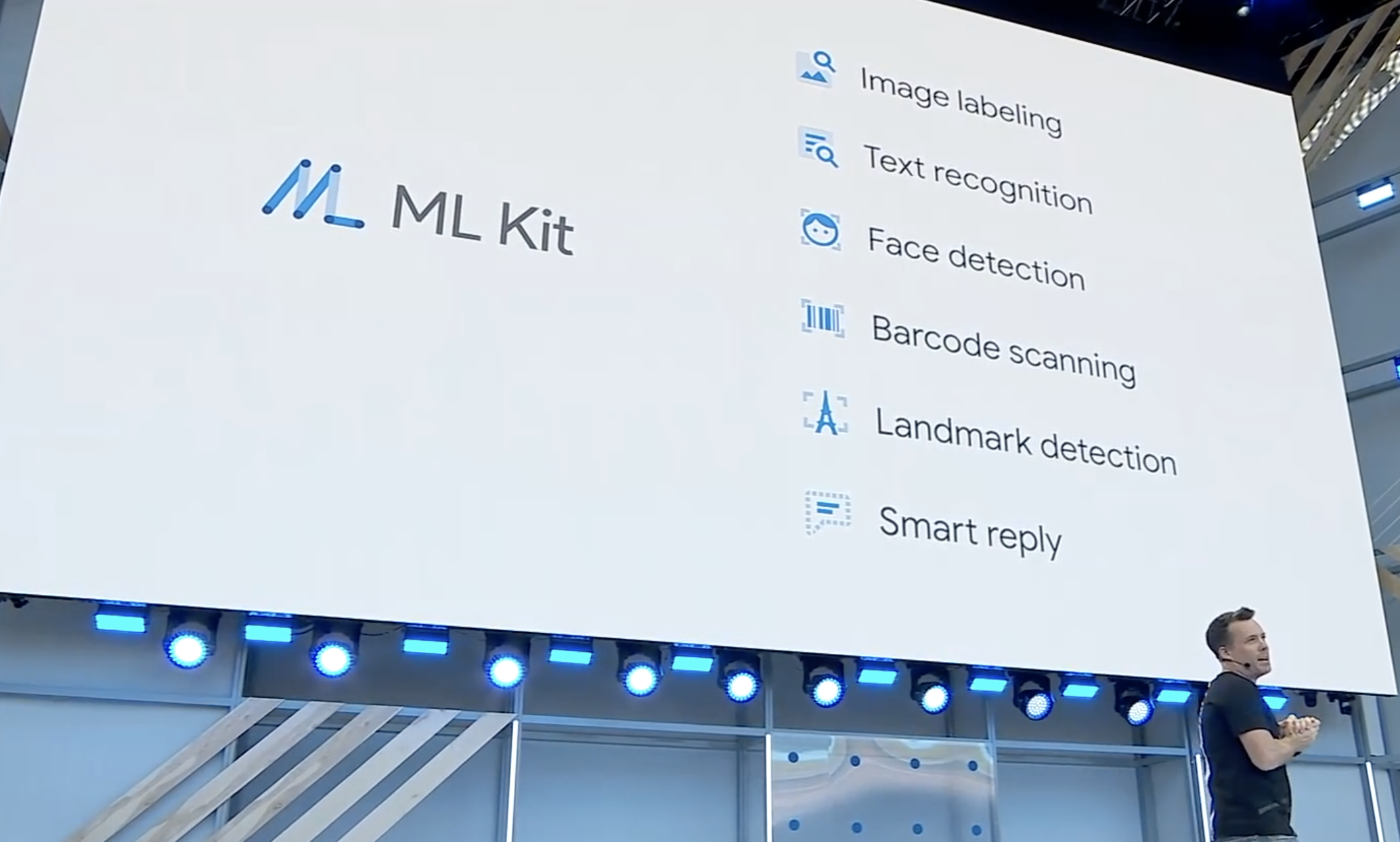

ML Kitは、スマホ上で利用できるMachine LearningのAPI群のことで、一般の企業がアプリを作る際に、GoogleのようなAIの機能を簡単に実装できます。

これまでもこうしたAPIはGoogle Cloud経由で利用ができましたが、今回スマホ上(On-Device)での利用が可能となった、ということで、Googleが実装しているような高速な文字認識や画像認識を誰でもアプリで実装できるようになりました。

Androidだけでなく、iOSでも利用できるということで、「自社のアプリでAIを使いたい」と考えられている企業の方は、ぜひ使ってみると良いと思います。

すでにいくつかのパートナーが実装しているようですが、カロリー管理アプリのLose It!では、食品のパッケージの文字を認識して栄養情報を取り込んだり、食べようとしている料理の写真を認識して分類したりという機能が実装されているようです。

Landmark Detection(建物認識)、Smart Reply(自動返信)などのAPIも用意されており、実現できることは非常に幅広く、2018年の後半はML Kitを活用した「AIアプリ」が数多く登場することになりそうです。

AIの進化②:AR Core

二つ目は、3ヶ月前に正式にリリースされたGoogleのARプラットフォーム「AR Core」です。

カメラを通して周辺の環境を正確に認識して画像を重ねて表示できる機能を使い、家の壁や床を正確に認識して自宅の家具の配置を決めるアプリ、3次元の骨格図を表示して勉強することができるアプリ、自宅の机の上にゲームボードを置くアプリなど、様々なカテゴリーのアプリが生まれ始めています。

今回AR Coreにいくつかの機能が発表されましたが、そのうち2つを紹介します。

「Augumented Images」は、商品のパッケージなどを認識して、その上にリアルタイムかつ正確に映像を乗せることができるというものです。

以下の動画(40秒くらいから)を見るとイメージがわくと思います。教科書を動く教科書にしたり、商品のパッケージを開ける前に調理イメージが見える、みたいな機能の実現が可能です。

プロモーションやコマースなどではデファクト的な機能になっていきそうです。

もう一つが、「Cloud Anchors」です。

Facebookのf8で発表された新しいVRヘッドセット、OculusGoの一つの特徴が「ソーシャルの進化」でしたが、Cloud Anchorsも、「ARのソーシャル化」に繋がる大事な機能です。

PokemonGoは、あくまでユーザ毎に同じ場所にいるポケモンを見ているだけでしたが、Cloud Anchorsでは、複数の人でインタラクティブに同じAR世界を共有できるというものです。

以下の動画(32秒くらいから)を見るとイメージがわくと思いますが、二人のスマホを連携させて、ARアプリを楽しむことができます。まずは、ゲームなどで、PokemonGoの進化版やモンストの進化系みたいなものが出てきそうな気がします。

AIの進化③:Google Assistant

三つ目は、「Google Assistant」です。

先行するAmazon Alexaから大きく遅れを取っていたGoogle Assistantですが、「搭載台数5億台」「対応自動車ブランド40」「対応デバイス5,000種」と、Androidと同じオープン戦略で一気に追い上げています。

今回Google Assistant関連では様々な発表がありましたが、3つを紹介したいと思います。

一つ目は、もっとも大きくバズった「Google Duplex」です。

傘下のDeepMindが開発したWavenet(自然な合成音声を生成する技術)を元にした機能で、人間の代わりにAIが電話をかけることができるようになりました。

動画では、散髪の予約(1:10〜)、レストランの予約(3:00〜)などを行っていますが、音声の自然さはもとより、複雑なやり取りを正確にこなしていることに驚かされます。

この技術の応用範囲は広範で、現在人がかけている様々な面倒な電話でのやり取りの多くを、将来的に代替する事が可能になります。

営業電話、コールセンター、などなど、あっという間に、多くの電話はAIに取って代わられることになりそうです。

Sundarが言っていた、「Google Mapでレストランのオープン時間を調べる人は多い。ただ、休日は本当に空いているか分からずに、お店に直接電話してしまう人がとても多い。これをDuplexが代わりに一本電話をして、Google Mapを更新できるようになる」というユースケースは、確かに有効そうです。

「自在に会話ができる」ようになりつつあるAIが、何に活用できるのか、DuplexがML Kitに追加される前に考えておくのもいいかもしれません。

二つ目は、「Actions On Google」です。

Google Assistantの機能をより幅広いユーザに使ってもらうために、以下の三つの新しい仕様が発表されました。

一つめは「Action Links」。

ブログなどに、Actionへのリンクを貼る事ができるようになりました。

地味ではありますが、Google Assistantの利用をジワリと後押ししそうです。

二つ目は、「Action Notifications」。

アプリ同様、Actionを継続的に利用し続けてもらう、というのは多くのケースで課題でした。

Action Notificationsでは、一度Actionを使ってもらったユーザに対して、アプリのように、スマホやスピーカーからNotificationを出すことができるようになりました。

最後は、「Routine Suggestions」。

私は使ったことがないのですが、AIスピーカーでは、この「Routine」を使っている人が多いようなのです。

例えば、Google Assistantに対して、「Let’s go to work」というと、カーナビをオフィスにセットして、ニュースを流して、いつものスタバのコーヒーを注文するという、毎朝行う操作を一気にしてくれる、というものです。

Routine Suggentionsを使うと、Actionを使ってもらった最後に、「Routineに追加しますか」というメッセージを出すことができます。

以上が、Actions on Googleの三つの機能です。

もう一つ、Google Assistantに追加された新機能は「Subscribe with Google」です。

Google Assitantのもう一つの課題は「マネタイズ」でした。

Subscribe with Googleでは、ニュースなどの有料コンテンツの提供が可能となり、スマホなどで有料登録をすると、Google Homeなど他のデバイスでも有料コンテンツが利用できるようになりました。着実な進化の方向性だと思います。

後発で最大のスマホプラットフォームとなったAndroidのように、AIアシスタントでも、着実にAmazon Alexaを追撃する体制を整えていることを感じさせる機能追加でした。

AIの進化④:Android

「Android」に関しても多くの発表がありました。

詳細な内容は他のニュース(Google I/O 2018で発表された「Android P」の新機能まとめ #io18)に譲るとして、ここでは「AIを活用した新しいUX」として、誰もが理解をしておくべき二つの進化について触れたいと思います。

一つ目が、「App Actions」です。

昨年から「Predictive Apps」と言って、Androidでアプリを検索しようとすると、次に開くであろうアプリの一覧が表示されるようになっています。この正解率は60%ということですから、結構高いですね。

App Actionsは、もう一段深い予測に基づいた機能です。

一番左は、単に「電話」機能の利用を予測するだけでなく、「誰に電話するのか」というところまで予測をして表示しています。これをクリックすると、単に「電話」機能が立ち上がるだけでなく、特定に連絡先への通話が始まります。

真ん中は、イヤホンをさしているときに、「音楽アプリ」の利用を予測するだけ出なく、前に聞いていたLady Gagaを再生するであろうと予測しています。

最後は、「Infinity」と検索窓にタイプすると、「Infinity War」という映画の情報を検索するであろうと予測し、さらにその「チケットの予約」か「動画の再生」を予測し、関連アプリを表示します。

このように、アプリの表示にとどまらず、過去の履歴や入力内容などから、二手先まで予測するのがApp Actionsです。Predictive Appsの数字を見ても、かなり高い精度の予測になるであろうことは想像に難くないので、ユーザにとってはかなり便利な機能になりそうです。

もう一つは「Slices」です。

これはライドシェアアプリ、Lyftの例ですが、ユーザの過去の利用履歴などから、検索結果に「家までのルート」「オフィスまでのルート」など、そしてその所要時間や費用なども表示する事ができます。それぞれをタップすると一気に依頼までできるので、ユーザの操作がかなり削減されて、便利な事が間違いないインターフェースです。

Androidの二つの機能を紹介しましたが、多くの消費者はこうしたAIを活用した二手先を読んだUXにどんどん慣れていきます。

ネットに限らず、リアルの場においても、同様のレベルのUXが求められることを理解しておく必要があります。

AIの進化⑤:Waymo

5番目は、自動運転子会社の「Waymo」です。

昨年一部門から独立した会社となったWaymoは、すでにArizona州で完全無人の自動運転カーの公道テストを開始しています。

これが一般人向けの実際のテストの動画ですが、降りるときの「Thank you, Car ! 」って言うの未来っぽくていいですね。

今年の後半には、テストではなく商用のサービスもいよいよ始まります。

詳細な説明はありませんでしたが、ArizonaのPhoenixにはこのようなサインが設置され、アプリから無人の自動運転カーを呼ぶことができると言うことです。

もう一つ、WaymoのCEOのJohnが大事なことを言っていました。

「我々は新しい自動車を作っているのではない。新しいドライバーを作っているのだ」

思想は、Android、Assistantと同じだと思います。この写真にあるように、乗用車だけでなく、バスでもトラックでも運転できる「AIドライバー」を開発しているということなのです。

また、技術的にWaymoが今どの辺にあるのかと言う点についても言及がありました。

この写真では、左下にあるように、人が板を運んでいて、体がほとんど隠れていますが、ちゃんと人間として認識しています。

「認識(Perception)」だけでなく、様々な「予測(Prediction) 」にも取り組んでいます。

動画を見るとよくわかるのですが、このシーンでは右側から明らかな信号無視で車が突っ込んできます。

それをWaymoは、その車が減速をしていないことや、信号の色などの情報を組み合わせて「信号無視する」と予測をして、図にあるように赤い仮想の壁を作って自分が減速して、衝突を回避しています。これはすでに、我々人間の危機回避能力を超えていますよね。

これはバーチャルワールドでの、自動運転シミュレーションです。

Googleはいち早く自動運転カーの開発に取り組み、今では、一般のドライバーが運転する一年分の距離を毎日走り、これまでにトータルで600万マイルという距離のテストをしてきたそうです。

加えて、上のバーチャルワールドでも、同時に2万5000台の車を毎日走らせているということです。リアルな環境での走行と組み合わせることで、トレーニングと検証をものすごいスピードで繰り返しているということです。

また、カリフォルニアはいいけど、雪が降る東海岸で自動運転は難しいよねと言われるのは、雪が降ると周辺の環境認識が難しくなるためです。

これは左下にあるような雪がふる環境でのセンサーのローデータです。雪に反応してしまって何にも見えません。

それが今では、雪が降る厳しい環境下でも、このレベルまでクリアに見えるようになっているということです。

今年に入ってTeslaのAuto Pilotの死亡事故、UBERの自動運転テスト車による死亡事故などネガティブなニュースが相次ぎましたが、Waymoは自動運転カーの商用化に向けて着実にステップを踏んでいるような気がします。

AIの進化⑥:Google Lens

次は、昨年のGoogle I/Oで発表された画像検索機能「Google Lens」です。

これまではGoogle PhotoとGoogle Assistantなどからしか使えなかったのですが、今年から様々なメーカーのスマホのカメラに実装が始まり、カメラを立ち上げるだけで画像検索が使える時代が来るようです。1990年代からこの分野にスタートアップとして取り組んでいた身としては、何というか改めて感動的です。

さて、今回発表された3つの新機能について紹介します。

一つめは、「Smart Text Selection」です。

カメラに映る文字を選択して、その情報を検索することが可能になります。

これまでも文字をその場で翻訳した結果を表示することができましたが、Smart Text Selectionを使うと、食べたいメニューの見た目や細かいレシピをカメラから調べたりすることもできるようになります。

二つ目は、「Style Match」です。

画像の中でオブジェクトと認識されたものには丸いアイコンが表示されるようになり、それをタッチすると、似ている商品の情報を見ることができます。ショッピング分野で様々な応用が可能な技術です。

最後は「Real-time Results」です。

画像を認識して結果を下に表示するだけでなく、映画のポスターであればTrailerを、音楽のポスターであればMVを画像の上にリアルタイムで再生することができます。全く新しい直感的な検索手法になりそうです。広告表現としても全く新しいものが生み出されそうな予感がします。

贅沢な話ですが、これら全てがスマホのカメラに実装されるということで、「カメラをかざすだけで検索」という新しい検索スタイルが普及していきそうな気がします。素晴らしいです。

AIの進化⑦:TPU

最後は、昨年発表されたMachine Learning用チップ「TPU」です。

今回発表されたTPU3.0は、去年よりも8倍も高速になっているということです。8%ではありません、8倍です。とんでもない進化ですね。

冒頭に地味なGoogle I/Oだったと書きましたが、「AIの一般化を加速する」ML Kit、「ARのソーシャル化を進める」AR Core、「AIが喋る」Duplex、「二手先の行動を読む」Andoroid、「赤信号無視を予測する」Waymo、「町中認識できる」Google Lens、とどれも我々人類の生活を大きく変えてしまいそうな、AIの進化です。

この発表を受けて、どんなアプリやサービスが生み出されていくのか楽しみですね。本当に素晴らしい。